python适用于端边云场景的新型开源深度学习训练/推理框架 可用于移动、边缘和云场景。

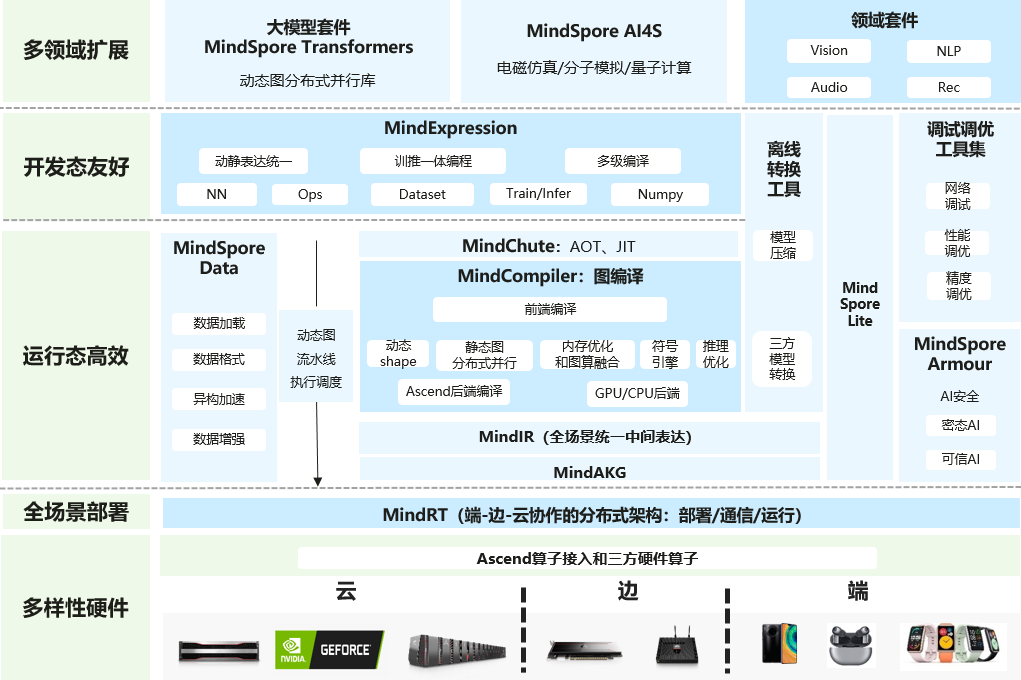

一种适用于端边云场景的新型开源深度学习训练/推理框架。提供了友好的设计和高效的执行,旨在提升数据科学家和算法工程师的开发体验,并为Ascend AI处理器提供原生支持,以及软硬件协同优化。 同时,作为全球AI开源社区,致力于进一步开发和丰富AI软硬件应用生态。

python适用于端边云场景的新型开源深度学习训练/推理框架 可用于移动、边缘和云场景。 ...

自动微分当前主流深度学习框架中有两种自动微分技术: - 操作符重载法: 通过操作符重载对编程语言中的基本操作语义进行重定义,封装其微分规则。 在程序运行时记录算子过载正向执行时网络的运行轨迹,对动态生成的数据流图应用链式法则,实现自动微分。

- 代码变换法: 该技术是从功能编程框架演进而来,以即时编译(Just-in-time Compilation,JIT)的形式对中间表达式(程序在编译过程中的表达式)进行自动差分转换,支持复杂的控制流场景、高阶函数和闭包。

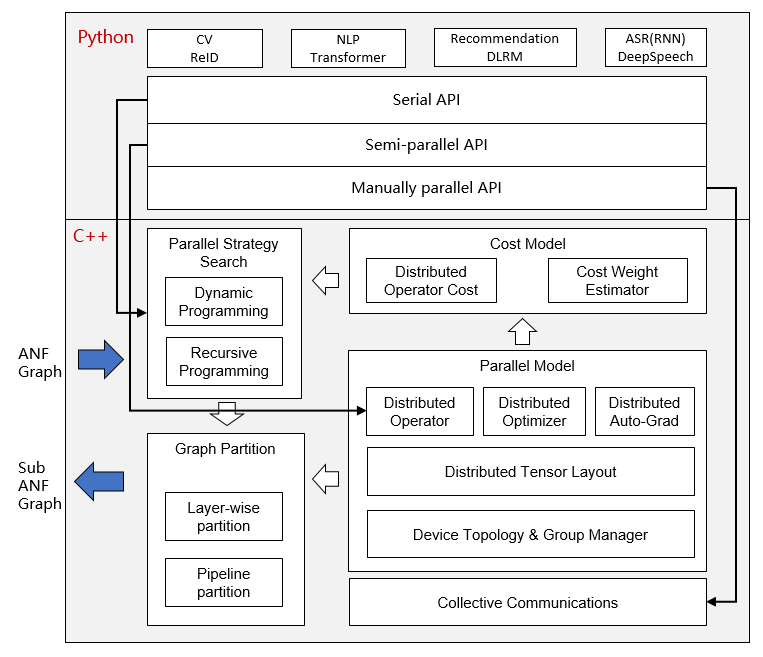

PyTorch采用的是操作符重载法。相较于代码变换法,操作符重载法是在运行时生成微分计算图的, 无需考虑函数调用与控制流等情况, 开发更为简单。 但该方法不能在编译时刻做微分图的优化, 控制流也需要根据运行时的信息来展开, 很难实现性能的极限优化。 则采用的是代码变换法。一方面,它支持自动控制流的自动微分,因此像PyTorch这样的模型构建非常方便。另一方面,MindSpore可以对神经网络进行静态编译优化,以获得更好的性能。 自动微分的实现可以理解为程序本身的符号微分。MindSpore IR是一个函数中间表达式,它与基础代数中的复合函数具有直观的对应关系。复合函数的公式由任意可推导的基础函数组成。 IR中的每个原语操作都可以对应基础代数中的基本功能,从而可以建立更复杂的流控制。 自动并行自动并行的目的是构建数据并行、模型并行和混合并行相结合的训练方法。该方法能够自动选择开销最小的模型切分策略,实现自动分布并行训练。

python适用于端边云场景的新型开源深度学习训练/推理框架 可用于移动、边缘和云场景。 ...

目前采用的是算子切分的细粒度并行策略,即图中的每个算子被切分为一个集群,完成并行操作。在此期间的切分策略可能非常复杂,但是作为一名Python开发者,您无需关注底层实现,只要顶层API计算是有效的即可。 安装pip方式安装提供跨多个后端的构建选项: [td]| 硬件平台 | 操作系统 | 状态 | | Ascend | Ubuntu-x86 | ✔️ | | Ubuntu-aarch64 | ✔️ | | EulerOS-aarch64 | ✔️ | | CentOS-x86 | ✔️ | | CentOS-aarch64 | ✔️ | | GPU CUDA 10.1 | Ubuntu-x86 | ✔️ | | CPU | Ubuntu-x86 | ✔️ | | Ubuntu-aarch64 | ✔️ | | Windows-x86 | ✔️ |

使用pip方式,在不同的环境安装,可参考以下文档。 - Ascend环境使用pip方式安装

- GPU环境使用pip方式安装

- CPU环境使用pip方式安装

源码编译方式安装使用源码编译方式,在不同的环境安装,可参考以下文档。 - Ascend环境使用源码编译方式安装

- GPU环境使用源码编译方式安装

- CPU环境使用源码编译方式安装

链接:https://pan.quark.cn/s/c7c4926d75fc

提取码下载:

|  |免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图

|免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图