Ollama实现本地部署DeepSeek!

一、环境准备硬件需求:

- 最低配置:CPU(支持 AVX2 指令集)+ 16GB 内存 + 30GB 存储。

- 推荐配置:NVIDIA GPU(RTX 3090 或更高)+ 32GB 内存 + 50GB 存储。

软件依赖:

- 操作系统:Windows、macOS 或 Linux。

二、安装 Ollama访问 Ollama 官网:前往 Ollama 官网,点击“Download”按钮。

Ollama实现本地部署DeepSeek!

- 下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

- 验证安装:安装完成后,在终端输入以下命令,检查 Ollama 版本:

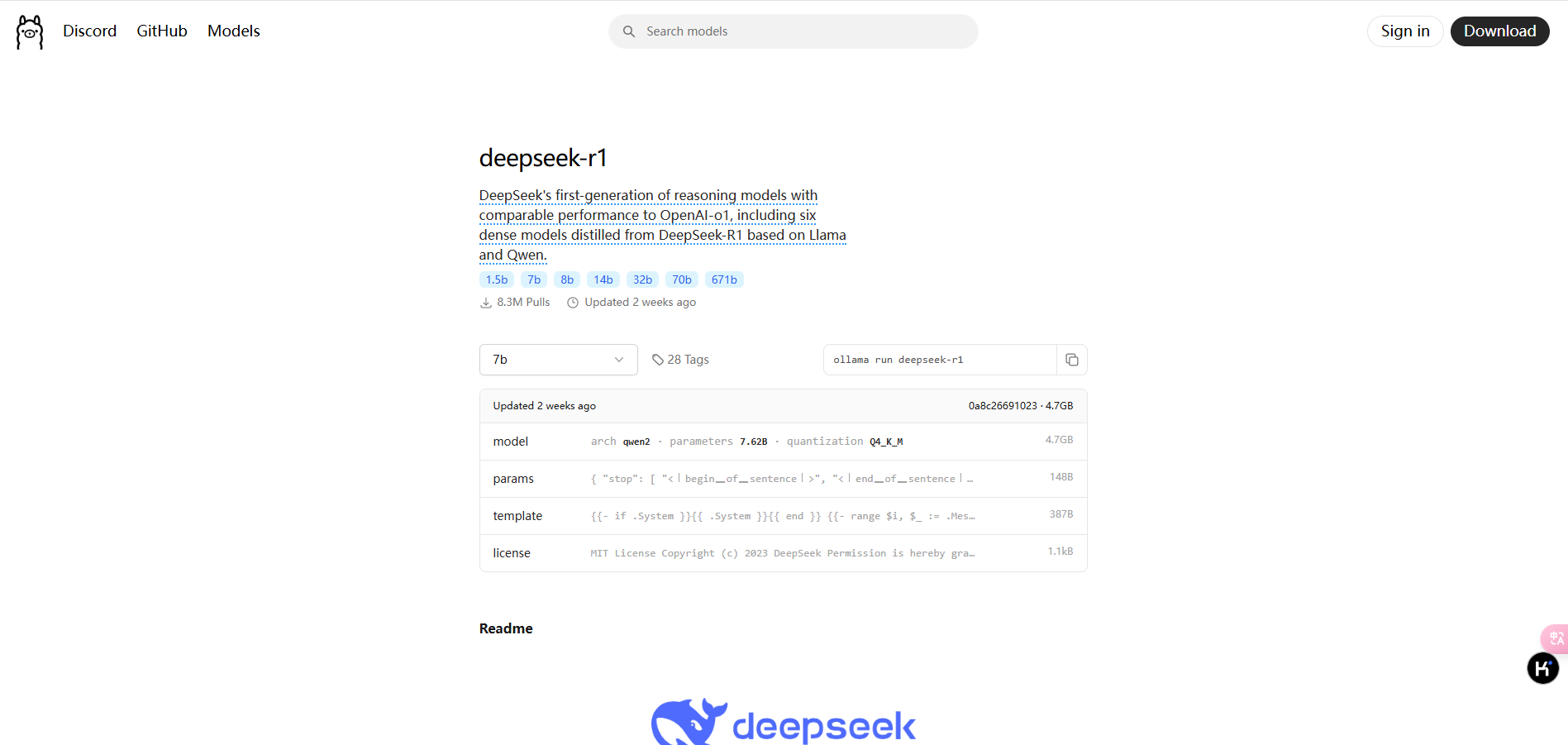

三、下载并部署 DeepSeek 模型选择模型版本:根据硬件配置选择合适的模型版本。常见的模型版本包括:

Ollama实现本地部署DeepSeek!

- 入门级:1.5B 版本,适合初步测试。

- 中端:7B 或 8B 版本,适合大多数消费级 GPU。

- 高性能:14B、32B 或 70B 版本,适合高端 GPU。

下载模型:打开终端,输入以下命令下载并运行 DeepSeek 模型。例如,下载 7B 版本的命令为: - ollama run deepseek-r1:7b

需要下载其他版本,可以参考以下命令: - ollama run deepseek-r1:8b # 8B 版本

- ollama run deepseek-r1:14b # 14B 版本

- ollama run deepseek-r1:32b # 32B 版本

启动 Ollama 服务:在终端运行以下命令启动 Ollama 服务: 服务启动后, 可以通过访问 http://localhost:11434 来与模型进行交互。 通过命令行使用并不方便,有些客户端挺好用:Chatbox 和Cherry Studio 可以自行了解。

当然,部署小版本的其实使用效果并不好,还不如直接使用官网提供的 |  |免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图

|免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图