OpenAI 的开源替代方案,自己部署大模型,无需GPU

免费、开源的 OpenAI 替代方案。自托管、社区驱动、本地优先。在消费级硬件上运行的 OpenAI 的直接替代品。无需 GPU。运行 ggml、gguf、GPTQ、onnx、TF 兼容模型:llama、llama2、rwkv、whisper、vicuna、koala、cerebras、falcon、dolly、starcoder 等

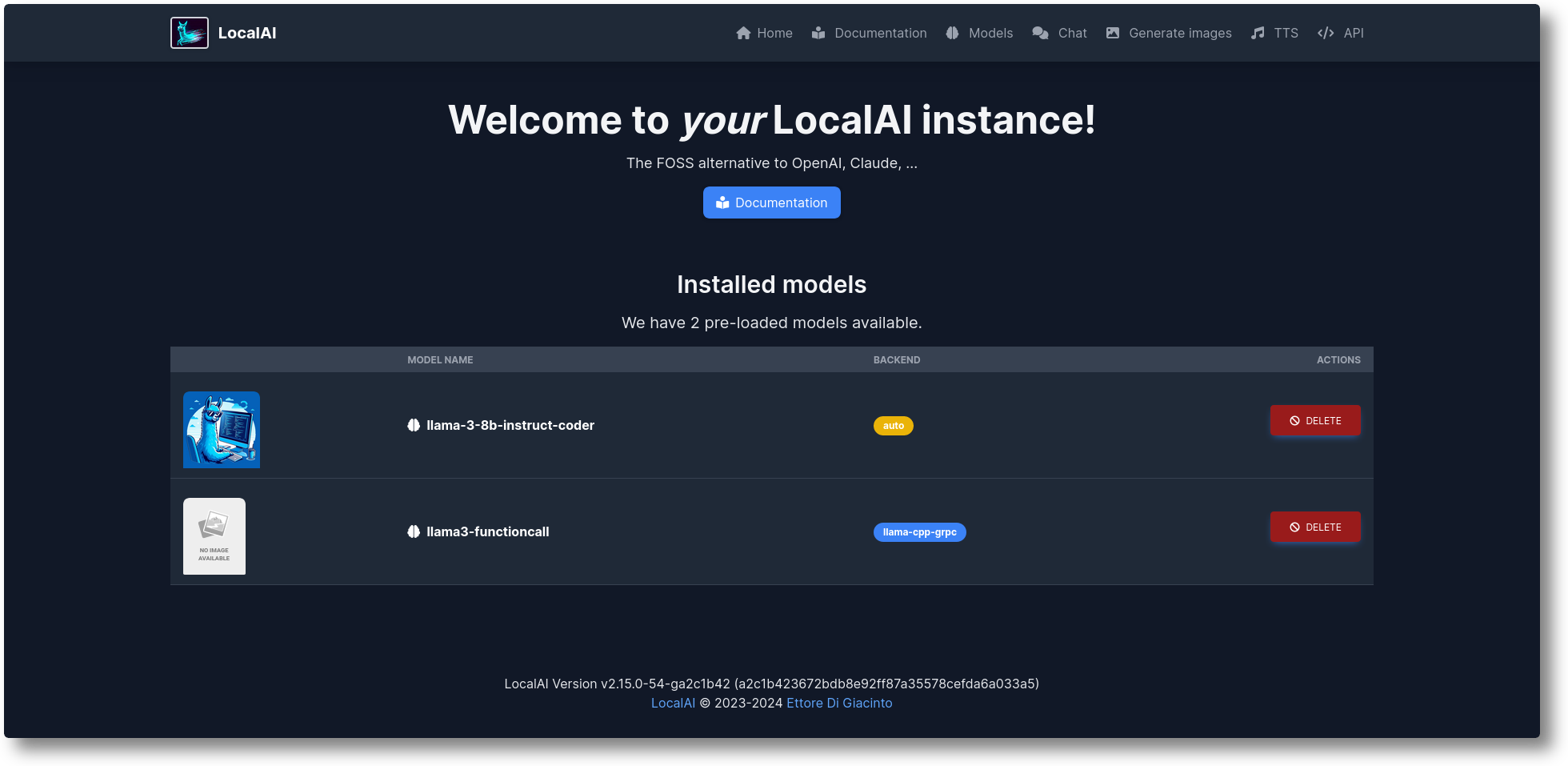

LocalAI是免费的开源 OpenAI 替代品。LocalAI 充当 REST API 的直接替代品,与本地推理的 OpenAI API 规范兼容。它允许您使用消费级硬件在本地或本地运行 LLM、生成图像、音频(不仅如此),支持多个模型系列。不需要 GPU。

LocalAI 是一个开源项目,旨在为开发者提供一个免费且易于使用的本地人工智能解决方案。它旨在与 OpenAI 的 API 规范兼容,使得开发者能够在不使用 OpenAI 的服务的情况下,也能够利用类似的功能。LocalAI 支持多种模型系列,包括语言模型和图像、音频生成模型等。 LocalAI 的特点包括: 1. 开源性:LocalAI 是开源的,这意味着其源代码可以被任何人自由地查看、修改和分发。 2. 免费使用:LocalAI 提供免费的使用权限,开发者可以不花钱就使用其功能。 3. 本地推理:LocalAI 支持在本地硬件上进行推理,这意味着不需要连接到云服务或使用远程服务器。 4. 消费级硬件:LocalAI 能够在消费级硬件上运行,不需要高性能的 GPU 或特殊的硬件支持。 5. 模型兼容性:LocalAI 支持多个模型系列,开发者可以根据自己的需求选择合适的模型。 6. API 兼容性:LocalAI 的接口设计是为了与 OpenAI 的 API 规范兼容,以便开发者可以较为简单地将现有的 OpenAI 代码迁移到 LocalAI。 LocalAI 的出现为那些希望避免使用中心化服务或出于隐私和安全考虑而希望将数据留在本地环境的开发者提供了一个替代选择。然而,需要注意的是,尽管 LocalAI 提供了一些便利,但它可能并不完全能替代 OpenAI 的服务,特别是在模型性能和功能方面。 开发者在使用 LocalAI 时应根据自己的需求和期望进行评估。 如何开始运行 LocalAI 最简单的方法是使用docker compose或与 docker(要在本地构建,请参阅构建部分)。 LocalAI 至少需要一个模型文件或一个配置 YAML 文件,或两者都需要。您可以使用配置文件自定义进一步的模型默认值和特定设置 容器镜像要求: 为了建立LocalAI您可以在本地使用容器镜像docker, 例如: - # build the image

- docker build -t localai .

- docker run localai

本地为了在本地构建LocalAI,您需要满足以下要求: Golang >= 1.21 Cmake/make GCC GRPC

要使用以下命令构建 LocalAI make: - git clone LocalAI

- cd LocalAI

- make build

这应该会产生二进制文件local-ai

LocalAI是免费的开源 OpenAI 替代品方案,自己部署大模型,无需GPU

游客,本帖隐藏的内容需要积分高于 2 才可浏览,您当前积分为 0

提取码下载:

|  |免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图

|免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图